학사/아주대 융시공

-

[4학년][1학기][Coursera][Mathematics for ML][W5]2025.04.28

[4학년][1학기][Coursera][Mathematics for ML][W8]

시험 기간 이슈로 week6, 7을 건너뛰게 되었습니다.

Mathematics for Machine Learning: Linear Algebra

Coursera - Imperial College London

Link to Course

Matrices, Vectors, and solving simultaneous equation problems

Apples and Bananas 문제 복습

- 예를 들어, 어떤 가게에서 사과 2개, 바나나 3개를 사는데 8유로가 들었다고 하자.

- 다른 날에는 사과 10개, 바나나 1개를 사는데 13유로가 들었다.

- 이때 사과 1개, 바나나 1개의 가격을 알아내는 것이 목표.

이 문제는 단순한 simultaneous equations(연립 방정식) 문제이지만, Matrices(행렬) 을 이용해서 표현할 수 있다.

Matrix 표현

다음과 같은 형태로 행렬을 설정할 수 있다:

Coefficient Matrix:

$$

\begin{bmatrix}

2 & 3 \

10 & 1

\end{bmatrix}

$$Variable Vector:

$$

\begin{bmatrix}

a \

b

\end{bmatrix}

$$

- Result Vector:

$$

\begin{bmatrix}

8 \

13

\end{bmatrix}

$$

이것은 다음 연립방정식과 동일함:

$$

2a + 3b = 8, \quad 10a + 1b = 13

$$

Matrix의 연산 방법

- Matrix와 Vector를 곱할 때는 Row × Column 연산을 한다.

- 첫 번째 행을 변수 벡터와 내적하여 결과 벡터의 첫 번째 원소를 얻고, 두 번째 행으로 두 번째 원소를 얻는다.

- 즉,

- 첫 번째 행: (2a + 3b = 8)

- 두 번째 행: (10a + 1b = 13)

→ 이는 기존 연립방정식과 정확히 일치한다.

Matrix의 의미

- 행렬은 벡터를 회전(rotation) 하고 늘리거나 줄이는(stretch) 연산을 수행하는 도구이다.

- 또한 행렬은 벡터 공간을 변환하여 문제를 해결하는 데 사용된다.

- 즉, 행렬은 입력 벡터(input vector) 를 받아 출력 벡터(output vector) 로 변환하는 함수(function)처럼 동작한다.

Basis Vector의 변환

- 표준 단위벡터 ( e_1 = [1,0] ), ( e_2 = [0,1] )을 생각해보자.

행렬을 ( e_1 )에 곱하면:

- ( 2 \times 1 + 3 \times 0 = 2 )

- ( 10 \times 1 + 1 \times 0 = 10 )

결과:

$$

\begin{bmatrix}

2 \

10

\end{bmatrix}

$$

행렬을 ( e_2 )에 곱하면:

$$

\begin{aligned}

2 \times 0 + 3 \times 1 &= 3 \

10 \times 0 + 1 \times 1 &= 1

\end{aligned}

$$

결과:

$$

\begin{bmatrix}

3 \

1

\end{bmatrix}

$$

→ 행렬은 단위벡터들을 새로운 벡터로 변환(transform) 한다.

선형대수(Linear Algebra)의 의미

- Linear(선형성) : 입력 값을 상수로 곱하고 더하는 방식으로 변환한다는 의미. (비틀거나 접지 않는다.)

- Algebra(대수) : 수학적 기호를 다루고 조작하는 체계(system).

즉, Linear Algebra는

- 벡터와 벡터 공간을 수학적으로 다루고 변환하는 방법론이다.

- 동시에, 연립방정식을 푸는 것도 결국 벡터 공간을 변환하는 과정임을 알 수 있다.

Summary

- 사과와 바나나 문제는 연립방정식으로, 이를 행렬을 이용해 표현할 수 있다.

- 행렬은 입력 벡터를 받아서 출력 벡터로 변환한다.

- 행렬을 단위벡터에 곱하면, 새로운 위치로 이동된 벡터를 얻을 수 있다.

- Linear Algebra는 벡터와 그 변환에 관한 체계이며, 이 개념은 문제 해결에 필수적이다.

How Matrices Transform Space

Matrix와 공간 변환의 관계

- 이전에는 Matrix를 이용해 연립방정식을 표현하는 방법을 배웠고,

- Matrix의 각 열은 단위벡터 ( e_1, e_2 )에 대해 어떤 변화를 주는지를 나타낸다고 했음.

이번에는 다양한 종류의 Matrix가 공간에 어떤 변화를 일으키는지,

그리고 하나의 Matrix 변환 뒤에 또 다른 Matrix를 적용하는 composition(합성) 을 다룬다.

벡터 변환과 선형성

벡터 ( r )을 Matrix ( A )로 변환한다고 하자:

$$

A r = r'

$$

이때, 중요한 성질은 다음과 같다:

- ( r )에 어떤 스칼라 ( n )을 곱한 후 변환하면:

$$

A(nr) = n(Ar) = nr'

$$

- 두 벡터의 합을 변환하면:

$$

A(r+s) = Ar + As

$$

즉,

- Matrix 변환은 스칼라 곱과 벡터 합에 대해 선형(linear)이다.

- 이로 인해 변환 후에도 공간의 격자선(grid lines)은 평행하고 균등 간격을 유지한다.

- 공간은 늘어나거나(Stretch), 기울어질(Shear) 수 있지만, 원점은 변하지 않고, 공간이 휘거나(curvy) 왜곡되지는 않는다.

변환된 Basis Vector로 이해하기

- 원래 벡터 ( r )은 단위벡터들의 선형 결합으로 표현할 수 있다:

$$

r = n e_1 + m e_2

$$

- Matrix ( A )를 적용하면:

$$

A r = n (A e_1) + m (A e_2)

$$

- 여기서 ( A e_1, A e_2 )는 각각 변환된 Basis Vector로 생각할 수 있다:

$$

A e_1 = e_1', \quad A e_2 = e_2'

$$

따라서:

$$

A r = n e_1' + m e_2'

$$

→ 즉, 변환된 Basis Vector들의 선형 결합으로 결과를 얻을 수 있다.

구체적인 예시

Matrix ( A )는 이전 Apples and Bananas 문제에서 사용한 다음과 같은 행렬이다:

$$

A = \begin{bmatrix}

2 & 3 \

10 & 1

\end{bmatrix}

$$

벡터

$$

r = \begin{bmatrix}

3 \

2

\end{bmatrix}

$$

에 대해 계산해보자.

직접 계산하면:

$$

A r =

\begin{aligned}

& 2 \times 3 + 3 \times 2 = 6 + 6 = 12 \

& 10 \times 3 + 1 \times 2 = 30 + 2 = 32

\end{aligned}

$$

결과:

$$

\begin{bmatrix}

12 \

32

\end{bmatrix}

$$

Basis Vector를 통한 접근

벡터 ( r )은 다음처럼 표현할 수 있다:

$$

r = 3 \times \begin{bmatrix} 1 \ 0 \end{bmatrix} + 2 \times \begin{bmatrix} 0 \ 1 \end{bmatrix}

$$

Matrix를 적용하면:

$$

A r = 3(A e_1) + 2(A e_2)

$$

각 변환을 계산해보자:

$$ A e_1 = \begin{bmatrix} 2 \ 10 \end{bmatrix} $$

$$ A e_2 = \begin{bmatrix} 3 \ 1 \end{bmatrix} $$

따라서:

$$

A r = 3 \times \begin{bmatrix} 2 \ 10 \end{bmatrix} + 2 \times \begin{bmatrix} 3 \ 1 \end{bmatrix}

$$

계산하면:

$$

= \begin{bmatrix} 6 \ 30 \end{bmatrix} + \begin{bmatrix} 6 \ 2 \end{bmatrix}

= \begin{bmatrix} 12 \ 32 \end{bmatrix}

$$

직접 계산한 결과와 동일하다.

요약

- Matrix는 단순히 단위벡터들을 새로운 위치로 이동시킨다.

- 벡터 전체는 이동된 단위벡터들의 선형 결합으로 표현할 수 있다.

- Matrix 변환은 공간을 휘거나 비틀지 않고, 선형(linear) 변환만 일으킨다.

- 변환 후에도 벡터 합, 스칼라 곱 등 벡터 연산의 규칙은 그대로 유지된다.

Types of Matrices Transformation

1. Identity Matrix

- 단위행렬(Identity Matrix)은 아무것도 변환하지 않는 행렬이다.

- 구성:

$$

I = \begin{bmatrix}

1 & 0 \

0 & 1

\end{bmatrix}

$$

이 행렬을 벡터

$$ \begin{bmatrix} x \ y \end{bmatrix} $$

에 곱하면 결과는 변하지 않는다:

$$

I \begin{bmatrix} x \ y \end{bmatrix} = \begin{bmatrix} x \ y \end{bmatrix}

$$

2. Scaling

- 대각선에 서로 다른 값이 있으면 축 방향으로 공간이 늘어나거나 줄어든다.

예:

$$

\text{Scaling Matrix} = \begin{bmatrix}

3 & 0 \

0 & 2

\end{bmatrix}

$$

- x축은 3배, y축은 2배로 스케일됨

- 만약 스케일 값이 1보다 작으면, 해당 방향으로 공간이 압축(squish)된다.

3. Reflection (뒤집기)

x축 반전

$$

\begin{bmatrix}

-1 & 0 \

0 & 1

\end{bmatrix}

$$

- x축을 기준으로 좌우 반전

y축 반전

$$

\begin{bmatrix}

1 & 0 \

0 & -1

\end{bmatrix}

$$

- y축을 기준으로 위아래 반전

원점 대칭 (Inversion)

$$

\begin{bmatrix}

-1 & 0 \

0 & -1

\end{bmatrix}

$$

- 모든 방향 반전 (x, y 둘 다 뒤집음)

45도 대칭 (축 뒤바꾸기)

$$

\begin{bmatrix}

0 & 1 \

1 & 0

\end{bmatrix}

$$

- x축과 y축을 서로 교환하는 효과 (45도 대칭)

또는:

$$

\begin{bmatrix}

0 & -1 \

-1 & 0

\end{bmatrix}

$$

- 반대 방향으로 교환하는 45도 대칭

4. Shear (전단 변환)

- 한 방향만 변형시키는 변환

예를 들어, e1은 그대로 두고, e2를 옆으로 밀면:

$$

\text{Shear Matrix} = \begin{bmatrix}

1 & 0 \

1 & 1

\end{bmatrix}

$$

- 이 변환은 원래 정사각형을 평행사변형으로 변형시킨다.

5. Rotation (회전)

- 공간을 회전시키는 변환

- 90도 회전 행렬 예:

$$

\text{90도 회전 Matrix} = \begin{bmatrix}

0 & 1 \

-1 & 0

\end{bmatrix}

$$

- 일반적인 2D 회전 행렬은 각도 ( \theta )에 대해 다음과 같다:

$$

\text{Rotation Matrix} =

\begin{bmatrix}

\cos \theta & \sin \theta \

-\sin \theta & \cos \theta

\end{bmatrix}

$$

- theta가 양수일 때, 반시계 방향 회전

- 예를 들어, -90도 회전이면 다음과 같이 계산한다:

$$

\sin(-90^\circ) = -1

$$

6. 데이터 과학에서의 활용

- 얼굴 인식(facial recognition)처럼 데이터의 orientation(방향성)을 맞추기 위해

Stretch, Mirror, Shear, Rotation 변환을 종종 사용한다. - 예를 들어, 얼굴을 카메라 방향에 맞추기 위해 회전 변환을 적용할 수 있다.

Summary

| 변환 종류 | 특징 |

|---|---|

| Identity | 변환 없음 |

| Scaling | 특정 축 방향으로 확대/축소 |

| Reflection | 좌우, 위아래 뒤집기 |

| Inversion | 원점 기준 전체 반전 |

| Shear | 한 방향으로 밀기(평행사변형) |

| Rotation | 특정 각도만큼 회전 |

Matrix는 공간을 변환하는 다양한 방법을 제공하며, 이들을 조합하여 복잡한 변환을 구성할 수 있다.

Composition or Combination of Matrix Transformations

1. 변환(Transformation) 조합의 필요성

- 복잡한 형태 변환(예: 얼굴 이미지 변형)은 회전(Rotation), 전단(Shear), 반사(Reflection), 확대/축소(Scaling) 변환을 조합해서 만들 수 있다.

- 변환을 순서대로 적용하여 복합적인 효과를 낼 수 있음.

2. 변환 순서: ( A_1 ) 후 ( A_2 )

벡터 ( r )에 대해:

- 먼저 변환 ( A_1 )을 적용

- 그 결과에 다시 변환 ( A_2 )를 적용

결국, 전체 변환은 ( A_2 A_1 r ) 이 된다.

3. 구체적인 예시

Step 1: Basis Vectors

초기 Basis Vectors:

$$

e_1 = \begin{bmatrix} 1 \ 0 \end{bmatrix}, \quad e_2 = \begin{bmatrix} 0 \ 1 \end{bmatrix}

$$

Step 2: 첫 번째 변환 ( A_1 ) — 90도 반시계 방향 회전

회전 행렬:

$$

A_1 = \begin{bmatrix}

0 & -1 \

1 & 0

\end{bmatrix}

$$

변환 결과:

$$

\begin{aligned}

e_1' &= \begin{bmatrix} 0 \ 1 \end{bmatrix} \

e_2' &= \begin{bmatrix} -1 \ 0 \end{bmatrix}

\end{aligned}

$$

Step 3: 두 번째 변환 ( A_2 ) — 수직 반사(Vertical Reflection)

반사 행렬:

$$

A_2 = \begin{bmatrix}

-1 & 0 \

0 & 1

\end{bmatrix}

$$

변환 결과:

- ( e_1 )은 ( (-1, 0) )으로 반사

- ( e_2 )는 변하지 않음

Step 4: ( A_2 )를 ( A_1 ) 결과에 적용 (즉, ( A_2 A_1 ))

( A_2 )를 ( A_1 )에 곱한다:

$$

A_2 A_1 = \begin{bmatrix}

-1 & 0 \

0 & 1

\end{bmatrix}

\begin{bmatrix}

0 & -1 \

1 & 0

\end{bmatrix}

$$

계산:

$$

\begin{aligned}

\text{First column} &: (-1) \times 0 + 0 \times 1 = 0,\quad 0 \times 0 + 1 \times 1 = 1 \

\text{Second column} &: (-1) \times (-1) + 0 \times 0 = 1,\quad 0 \times (-1) + 1 \times 0 = 0

\end{aligned}

$$

결과:

$$

A_2 A_1 = \begin{bmatrix}

0 & 1 \

-1 & 0

\end{bmatrix}

$$

4. 변환 순서가 바뀔 경우 (즉, ( A_1 A_2 ))

( A_1 )을 ( A_2 )에 곱한다:

$$

A_1 A_2 = \begin{bmatrix}

0 & -1 \

1 & 0

\end{bmatrix}

\begin{bmatrix}

-1 & 0 \

0 & 1

\end{bmatrix}

$$

계산:

$$

\begin{aligned}

\text{First column} &: 0 \times (-1) + (-1) \times 0 = 0,\quad 1 \times (-1) + 0 \times 0 = -1 \

\text{Second column} &: 0 \times 0 + (-1) \times 1 = -1,\quad 1 \times 0 + 0 \times 1 = 0

\end{aligned}

$$

결과:

$$

A_1 A_2 = \begin{bmatrix}

0 & -1 \

-1 & 0

\end{bmatrix}

$$

5. 중요한 결론

- Matrix multiplication은 교환법칙(commutative)을 만족하지 않는다.

$$

A_2 A_1 \neq A_1 A_2

$$

- 하지만, 결합법칙(associative)은 성립한다.

$$

A_3 (A_2 A_1) = (A_3 A_2) A_1

$$

Summary

| 성질 | 설명 |

|---|---|

| 선형성(Linearity) | 벡터 합과 스칼라 곱에 대해 선형 유지 |

| 결합법칙(Associativity) | 괄호 위치에 관계없이 순차 적용 가능 |

| 비가환성(Non-commutativity) | 적용 순서가 결과에 영향을 줌 |

Matrix를 조합하여 복합 변환을 만들 수 있으며, 특히 데이터 과학, 컴퓨터 비전(얼굴 인식 등)에서 변환 순서를 정확히 관리하는 것이 중요하다.

Solving the Apples and Bananas Problem: Gaussian Elimination

1. 문제 설정

- 두 번 쇼핑을 함:

- 2 apples + 3 bananas = 8 euros

- 10 apples + 1 banana = 13 euros

이를 Matrix 형태로 표현하면:

$$

A = \begin{bmatrix} 2 & 3 \ 10 & 1 \end{bmatrix}, \quad

r = \begin{bmatrix} a \ b \end{bmatrix}, \quad

s = \begin{bmatrix} 8 \ 13 \end{bmatrix}

$$

- 식은 다음과 같이 정리할 수 있음:

$$

A r = s

$$

2. 역행렬(Inverse)을 통한 풀이 아이디어

- 역행렬 ( A^{-1} )이 존재하면:

$$

A^{-1} A = I

$$

- 양변에 ( A^{-1} )을 곱하면:

$$

A^{-1} A r = A^{-1} s

$$

즉,

$$

r = A^{-1} s

$$

- 역행렬을 구할 수 있다면 문제를 일반적으로 해결할 수 있음.

3. 굳이 역행렬을 구하지 않고도 풀 수 있는 방법: 소거법(Elimination)

예시: 3가지 품목(apple, banana, carrot)

Matrix:

$$

A = \begin{bmatrix}

1 & 1 & 3 \

1 & 2 & 4 \

1 & 1 & 2

\end{bmatrix}

$$

Vector:

$$

s = \begin{bmatrix}

15 \ 21 \ 13

\end{bmatrix}

$$

Row 1: 1 apple + 1 banana + 3 carrots = 15

Row 2: 1 apple + 2 bananas + 4 carrots = 21

Row 3: 1 apple + 1 banana + 2 carrots = 13

Step 1: Row Operation (Elimination)

- ( R_2 - R_1 ) :

$$

(1,2,4) - (1,1,3) = (0,1,1)

$$

- ( R_3 - R_1 ) :

$$

(1,1,2) - (1,1,3) = (0,0,-1)

$$

오른쪽 벡터도 동일하게 연산:

- ( 21 - 15 = 6 )

- ( 13 - 15 = -2 )

Step 2: 삼각형 형태로 정리 (Echelon Form)

변형된 행렬:

$$

\begin{bmatrix}

1 & 1 & 3 \

0 & 1 & 1 \

0 & 0 & -1

\end{bmatrix}

$$

오른쪽:

$$

\begin{bmatrix}

15 \ 6 \ -2

\end{bmatrix}

$$

Step 3: Back Substitution

- 세 번째 식에서 바로 알 수 있음:

$$

-1 \times c = -2 \quad \Rightarrow \quad c = 2

$$

- 두 번째 식에 ( c = 2 )를 대입:

$$

1 \times b + 1 \times 2 = 6 \quad \Rightarrow \quad b = 4

$$

- 첫 번째 식에 ( b = 4, c = 2 )를 대입:

$$

1 \times a + 1 \times 4 + 3 \times 2 = 15 \quad \Rightarrow \quad a = 5

$$

4. 최종 해

$$

a = 5, \quad b = 4, \quad c = 2

$$

- Apple: 5 euros

- Banana: 4 euros

- Carrot: 2 euros

5. 요약

| 용어 | 설명 |

|---|---|

| Elimination | 하나의 row를 다른 row에서 빼서 하위 요소를 0으로 만드는 과정 |

| Echelon Form | 주대각선 아래가 모두 0인 삼각형 형태의 행렬 |

| Back Substitution | 마지막 식부터 역방향으로 값을 대입하여 해를 구하는 과정 |

| 결과 | 원래 행렬을 Identity Matrix로 변환 |

변형 과정:

$$

\text{최종 행렬} =

\begin{bmatrix}

1 & 0 & 0 \

0 & 1 & 0 \

0 & 0 & 1

\end{bmatrix}

$$

6. 중요한 포인트

- 역행렬 없이도 Gaussian Elimination을 통해 문제를 해결할 수 있다.

- 하지만, 역행렬을 구하면 임의의 ( s )에 대해 ( r )을 빠르게 구할 수 있다.

- Gaussian Elimination은 연산 수가 적고 매우 효율적인 방법이다.

Going from Gaussian Elimination to Finding the Inverse Matrix

1. 문제 설정

- 3×3 행렬 ( A )와 그 역행렬 ( B )가 존재한다고 하자.

$$

A \times B = I

$$

- 예시로 사용하는 ( A ):

$$

A = \begin{bmatrix}

1 & 1 & 3 \

1 & 2 & 4 \

1 & 1 & 2

\end{bmatrix}

$$

- ( B )는 다음과 같은 미지수로 구성된 행렬이다:

$$

B = \begin{bmatrix}

b_{11} & b_{12} & b_{13} \

b_{21} & b_{22} & b_{23} \

b_{31} & b_{32} & b_{33}

\end{bmatrix}

$$

여기서 ( b_{ij} )는 ( i )번째 행, ( j )번째 열의 원소를 의미한다.

- Identity Matrix ( I ):

$$

I = \begin{bmatrix}

1 & 0 & 0 \

0 & 1 & 0 \

0 & 0 & 1

\end{bmatrix}

$$

2. 역행렬을 구하는 아이디어

- ( A \times B = I ) 이므로,

( B )는 ( A )의 역행렬 ( A^{-1} )이다. - 실제로는 다음과 같이 각각의 열(column)을 따로따로 푸는 방식으로 접근할 수 있다.

- 첫 번째 열을 풀 때는 ( A \times ) (B의 첫 번째 열) = (I의 첫 번째 열) 로 생각

- 두 번째 열, 세 번째 열도 동일

하지만! 모든 열을 한 번에 동시에 다루면 훨씬 효율적이다.

3. Gaussian Elimination 전체 과정을 통해 역행렬 구하기

초기 augmented matrix (확장된 행렬):

$$

\left[ \begin{array}{ccc|ccc}

1 & 1 & 3 & 1 & 0 & 0 \

1 & 2 & 4 & 0 & 1 & 0 \

1 & 1 & 2 & 0 & 0 & 1

\end{array} \right]

$$

Step 1: 첫 번째 열을 기준으로 제거

- ( R_2 - R_1 ) :

$$

(1,2,4) - (1,1,3) = (0,1,1)

$$

- ( R_3 - R_1 ) :

$$

(1,1,2) - (1,1,3) = (0,0,-1)

$$

오른쪽 벡터도 동일하게 갱신:

- ( (0,1,0) - (1,0,0) = (-1,1,0) )

- ( (0,0,1) - (1,0,0) = (-1,0,1) )

변형된 행렬:

$$

\left[ \begin{array}{ccc|ccc}

1 & 1 & 3 & 1 & 0 & 0 \

0 & 1 & 1 & -1 & 1 & 0 \

0 & 0 & -1 & -1 & 0 & 1

\end{array} \right]

$$

Step 2: 대각 성분을 1로 맞추기

- 세 번째 행 ( R_3 )을 (-1)로 나눔:

$$

R_3 \div (-1)

$$

변형 결과:

$$

\left[ \begin{array}{ccc|ccc}

1 & 1 & 3 & 1 & 0 & 0 \

0 & 1 & 1 & -1 & 1 & 0 \

0 & 0 & 1 & 1 & 0 & -1

\end{array} \right]

$$

Step 3: Back Substitution (역방향 대입)

- 세 번째 행을 이용해 두 번째 행에서 제거:

$$

R_2 \leftarrow R_2 - (1) \times R_3

$$

- 세 번째 행을 이용해 첫 번째 행에서 제거:

$$

R_1 \leftarrow R_1 - (3) \times R_3

$$

변형 결과:

$$

\left[ \begin{array}{ccc|ccc}

1 & 1 & 0 & -2 & 0 & 3 \

0 & 1 & 0 & -2 & 1 & 1 \

0 & 0 & 1 & 1 & 0 & -1

\end{array} \right]

$$

- 두 번째 행을 이용해 첫 번째 행에서 제거:

$$

R_1 \leftarrow R_1 - (1) \times R_2

$$

최종 결과:

$$

\left[ \begin{array}{ccc|ccc}

1 & 0 & 0 & 0 & -1 & 2 \

0 & 1 & 0 & -2 & 1 & 1 \

0 & 0 & 1 & 1 & 0 & -1

\end{array} \right]

$$

4. 최종 결과: 역행렬

오른쪽 부분이 바로 ( A^{-1} ):

$$

A^{-1} =

\begin{bmatrix}

0 & -1 & 2 \

-2 & 1 & 1 \

1 & 0 & -1

\end{bmatrix}

$$

5. 요약

| 용어 | 설명 |

|---|---|

| Elimination | 위 삼각 형태로 만들기 위해 row를 변환 |

| Back Substitution | 아래에서부터 값들을 차례로 구하는 과정 |

| 역행렬 | ( A^{-1} )을 구하면, 어떤 ( s )가 주어져도 ( r = A^{-1}s )로 바로 해를 구할 수 있음 |

6. 중요한 포인트

- Gaussian Elimination 과정을 통해 역행렬을 구할 수 있다.

- 수학적으로는

$$ A \times A^{-1} = I$$

가 항상 성립한다. - ( A^{-1} )을 알고 있으면, 모든 우변 ( s )에 대해 빠르게 해를 찾을 수 있다.

- 이 방법은 특히 고차원(수백×수백) 문제에서도 유용하다.

'학사 > 아주대 융시공' 카테고리의 다른 글

| [4학년][1학기][Coursera][Mathematics for ML][W5] (0) | 2025.04.28 |

|---|---|

| [4학년][1학기][Coursera][Introduction to HW and OS][W7] (0) | 2025.04.28 |

| [4학년][1학기][Coursera][Introduction to HW and OS][W6] (1) | 2025.04.28 |

| [4학년][1학기][Coursera][Introduction to HW and OS][W5] (0) | 2025.04.05 |

| [4학년][1학기][Coursera][Introduction to HW and OS][W4] (0) | 2025.03.30 |

[4학년][1학기][Coursera][Mathematics for ML][W5]

Mathematics for Machine Learning: Linear Algebra

Coursera - Imperial College London

Link to Course

Modulus and inner product

Vector는 length와 direction을 가지고 있음- 서로 orthogonal(직교)하는 두 개의 unit vector를 i와 j를 사용해 좌표계를 설정

- 임의의 vector

r은 다음과 같이 표현r=a⋅i+b⋅j

- Unit vector는 길이가 1인 vector

- hat 기호를 써서 나타냄

- Pythagoras theorem을 이용하면 vector

r의 길이는

$$ ∣r∣= \sqrt{(a^2+b^2)} $$

- 이 표현은 좌표계를 사용하는 vector의 일반적인 크기 정의

Dot product

- 내적, dot product는 두 vector를 곱하는 방법 중 하나

- 두 vector

r과s가 있을 때, 각각의 성분을 곱하고 그 합을 구함

$$r⋅s=(r_i * s_i)+(r_j * s_j)$$ - Dot product의 결과는 vector가 아니라

Scalar, 즉 숫자 하나

Properties of dot product

- 교환 법칙(Commutative)

- Dot product는 두 vector의 순서를 바꿔도 결과가 변하지 않음

$$ r⋅s=s⋅r $$

- 분배 법칙(Distributive over Addition)

- 덧셈에 대해 분배 법칙을 만족

- 세 vector

r,s,t가 있을 때

$$ r⋅(s+t)=r⋅s+r⋅t $$

- 스칼라 곱에 대한 결합 법칙(Associativity over Scalar Multiplication)

- Scalar 곱에 대해 결합 법칙 만족

- Scalar

a가 있을 때

$$ r⋅(as)=a(r⋅s) $$

Dot product과 modulus의 관계

- Vector를 자기 자신과 내적하면 각 성분의 제곱 합을 얻음

$$ r⋅r=r_1^2 +r_2^2 +⋯+r_n^2 $$

이 값은 vector의 크기 제곱과 동일

$$ r⋅r=∣r∣^2 $$Vector의 크기를 구할 때는 다음과 같은 편리한 공식 성립

$$ |r| = \sqrt{r⋅r} $$

Summary

벡터의 기본 연산(덧셈, 스칼라 곱)을 통해 벡터를 정의할 수 있다.

벡터의 크기(length)는 각 성분의 제곱 합의 제곱근으로 정의된다.

내적(dot product)은 벡터 간 곱의 한 종류이며, 결과는 숫자(스칼라)이다.

내적은 교환법칙, 분배법칙, 스칼라 곱에 대한 결합법칙을 만족한다.

벡터의 크기와 내적 사이에는 다음과 같은 중요한 관계가 있다:

$$ |r| = \sqrt{r⋅r} $$

Cosine and dot product

Cosine rule

길이가

a,b,c인 세 변으로 이루어진 삼각형

$$ c^2 =a^2 +b^2 −2abcosθ $$θ는 변 𝑎와 변 𝑏 사이의 각도

Vector 표현으로 바꿔보자

r,s가 있고 그 사이 각도를 θ두 vector를 이용하여 삼각형을 만들 수 있고

Vector의 뺄셈(r-s)을 이용하면 세 번째 변은 Vector

r-s로 표현Cosine rule을 Vector 표기법으로 다시 쓰면 다음과 같음

$$ ∣r−s∣^2 =∣r∣^2 +∣s∣^2 −2∣r∣∣s∣cosθ $$여기서 ∣𝑟∣, ∣𝑠∣는 각각 벡터 𝑟과 𝑠의 크기(길이)를 나타냄

Vector dot product를 이용한 전개

- 임의의 벡터의 크기의 제곱은 자기 자신과 내적한 값과 같다.

$$ ∣r−s∣^2 =(r−s)⋅(r−s)$$

전개하면

$$ (r−s)⋅(r−s)=r⋅r−r⋅s−s⋅r+s⋅s $$

이를 간단하게 정리하면,

최종적으로 아주 중요한 내적의 정의를 얻을 수 있음

$$ r⋅s=∣r∣∣s∣cosθ $$

Dot product의 의미 해석

- 내적은 두 vector의 크기와 사이의 각도의 Cosine 값에 따라 결정됨

- 두 vector가 같은 방향을 향하면

- theta가 0이므로 두 vector 크기에 1을 곱함

- 이때 내적이 최대값이며 항상 양수

- 두 vector가 직각으로 만나면

- theta가 90이므로 0을 곱함

- 이때 내적은 0이 됨

- 두 vector는 orthogonal

- 두 vector가 정반대 방향이면

- theta가 180이므로 (-1)을 곱함

- 내적은 음수가 되며

- 방향은 서로 반대

Vector간 방향성의 정량화

내적을 통해 우리는 두 vector가 얼마나 비슷한 방향을 향하고 있는지 알 수 있음

내적 값이

- 크고 양수일수록 두 vector는 거의 같은 방향

- 0에 가까울수록 두 vector는 직교

- 음수일수록 두 vector는 반대 방향

Projection

Scalar projection

- 두 vector

r,s가 있을 때s를r위에 투영 - 두 vector 사이 각도 θ가 있음

- Cosine을 이용해 각도 θ의 Adjacent side(인접변)의 길이를 구할 수 있음

$$ cosθ= 인접변의 길이/∣S∣ $$

R⋅S=∣R∣∣S∣cosθ 에서

∣𝑆∣cos𝜃 부분은 바로 벡터 𝑆를 벡터 𝑅 위에 투영했을 때의 길이(인접변의 길이)와 정확히 일치

벡터 𝑅 방향으로 𝑆가 만든 그림자의 길이가 바로 투영

만약 벡터 𝑆가 벡터 𝑅에 직각(orthogonal)이라면, 투영 길이는 0이 될 것

$$ Scalar Projection of S onto R= \frac{R⋅S}{∣R∣} $$

- 이는 Scalar이며 vector

S가R방향으로 얼마나 겹쳐있는 지 나타내는 양

Vector projection

- Scalar projection은 방향성이 없음

- 방향 정보를 포함하기 위해 vector projection을 사용

$$ Vector Projection of S onto R = (\frac{R⋅S}{∣R∣^2})*R$$

- Scalar projection에 vector

R의 방향을 나타내는 unit vector를 곱한 것

𝑅 / ∣𝑅∣ 는 벡터 𝑅의 단위벡터(unit vector)이며, 벡터 투영은 벡터 𝑅 방향으로 향하는 하나의 벡터임

스칼라 투영: 벡터가 다른 벡터 방향으로 얼마나 겹쳐 있는지의 크기(길이)만을 나타낸다.

벡터 투영: 스칼라 투영과 더불어 방향 정보까지 나타내는 완전한 벡터로, 다른 벡터 방향으로 실제로 "겹쳐진" 벡터를 표현한다.

$$ Vector projection of S onto R=(\frac{R⋅S}{∣R∣} )\frac{R}{∣R∣} $$

앞부분인 𝑅⋅𝑆 / ∣𝑅∣ 는 스칼라 투영이며,

뒷부분인 𝑅 / ∣𝑅∣ 은 방향을 나타내는 단위벡터

직관적 이해

벡터 투영의 직관적 이해를 돕기 위해 예시를 들어보면 다음과 같습니다.

벡터 𝑆 위에 수직으로 빛을 비추어서 벡터 𝑅 방향으로 그림자를 만든다고 상상해 봅시다.

이때 만들어진 그림자의 길이가 스칼라 투영입니다.

그런데 우리는 이 그림자의 길이뿐만 아니라 그림자의 방향까지도 정확히 표현하고 싶습니다. 이때 벡터 투영이 필요합니다.

벡터 투영은 "그림자의 길이와 방향을 모두 포함한 벡터"입니다.

즉, 벡터 투영은 원래 벡터 𝑅과 같은 방향으로 향하며, 그 크기는 스칼라 투영의 크기와 같습니다.

Practice Assignment

83.33점 pass

Chaning basis

- 기저 변환

- 한 좌표계에서 다른 좌표계로 vector를 변환하는 방법(changing basis)

- Vector

r은 원점(origin)에서 출발하여 공간 상 어떤 지점으로 향하는 기하학적 객체 - 일반적으로 orthogonal unit vectors

e1,e2로 이루어진 좌표계를 사용

예를 들어,

단위벡터

𝑒1=[1,0], 𝑒2=[0,1]을 기준으로 벡터 𝑟이 "3칸 오른쪽, 4칸 위"를 의미한다면,

$$𝑟=3𝑒1+4𝑒2=[3,4]$$

- 좌표계를 정하는 방식은 임의적

- 반드시 unit vectors거나 직각일 필요 없음

- 임의의 다른 vector

b1,b2로 좌표계를 정의하면 기존 vectorr도 새로운 좌표계의 숫자 조합으로 표현 가능 - 이러한 기준 vectors를 Basis vectors라고 부름

- 벡터 𝑟이 𝑒 기저에서는 [3,4]이지만, 𝑏 기저에서는 다른 숫자로 나타날 것

Orthogonal unit vectors를 활용환 좌표 변환

- 새로운 basis vectors

b``,b2`가 orthogona하는 경우, dot product를 활용해 좌표 변환 가능 - 새로운 기저 벡터 𝑏1,𝑏2 가 다음과 같이 정의되어 있다고 하자.

$$𝑏1=[2,1], 𝑏2=[−2,4]$$

두 기저 벡터가 직교하는지 확인하려면 내적 계산

→ 내적 값은 0이므로 직교함

Projection을 이용한 좌표 변환

- Vector

r을b1,b2의 방향으로 projection

b1 방향으로 투영

$$ Proj_{b_1} (r)= \frac{10}{5}b_1 =2[2,1]=[4,2] $$b1 방향으로 투영

$$ Proj_{b_2} (r)= \frac{10}{20}b_2 =\frac{1}{2}[-2,4]=[-1,2] $$두 projection의 합으로 원래 vector 확인

- 두 vector projection을 더하면 원래 vector

r로 돌아옴

$$ Proj𝑏1(𝑟)+Proj𝑏2(𝑟)=[4,2]+[−1,2]=[3,4]$$

새로운 기저에서의 좌표값 표현

- Vector

r은 새로운 basis vectorb1,b2를 기준으로 다음과 같은 좌표값을 가짐

$$ r = 2b_1 + \frac{1}{2}b_2$$

Summary

벡터는 좌표계와 독립적으로 존재하는 수학적 객체이다.

벡터를 표현하는 좌표계는 임의적이며, 필요에 따라 변경할 수 있다.

직교(orthogonal)하는 새로운 좌표계를 사용하면, 내적을 활용하여 손쉽게 좌표 변환을 수행할 수 있다.

벡터 투영(projection)을 이용하면 벡터를 새로운 기저 벡터의 좌표계로 간단히 나타낼 수 있다.

Practice Assignment: Changing basis

100점 pass

Basis, vector space, and linear independence

Basis is a set of n vectors that

- 서로가 서로의 linear combination으로 표현되지 않음

- 따라서 서로가 linearly independent임

- 이 vector들의 모든 가능한 선형 결합이 vector 공간 전체를 나타냄

- 즉, 공간을 span함

- Basis vector들이 n개라면 그 vector 공간은 n-dimensional

Linear independence의 의미

- 특정 vector를 다른 vector들간의 linear combination으로 나타낼 수 없음

- 만약 어떤 vector가 다른 vector들의 선형 결합으로 나타내어진다면, 그 vector는 linearly dependent임

만약

$$ b 3 =a 1 b 1 +a 2 b 2$$

여기서, a1, a2가 Scalar일 때

이것이 성립한다면, b3는 기존 두 vector와 같은 평면에 놓이며 선형 종속임

Basis vector의 특성

기저 벡터로 선택하는 벡터들은 다음과 같은 조건을 반드시 만족해야 함

서로 선형 독립이어야 한다.

서로의 선형 결합을 통해 공간 전체를 표현할 수 있어야 한다(공간을 생성).

다만, 다음과 같은 조건은 필수적이지 않지만 실질적으로는 편리하기 때문에 자주 사용됨

벡터들이 길이가 1인 unit vectors 이면 계산이 편리하다.

벡터들이 서로 orthogonal이면 더욱 계산이 편리하다.

이렇게 길이가 1이고 직교하는 기저 벡터의 집합을 정규 직교 기저(orthonormal basis) 라고 부름

좌표계의 변환과 기저의 변경

Basis vector를 변경할 때, 기존의 좌표축을 새 좌표축 위로 projection함

이때 다음과 같은 특징

좌표계의 축을 변경하면 벡터를 나타내는 성분 값은 달라질 수 있다.

그러나 이 좌표 변환은 여전히 벡터 공간의 규칙성을 유지한다.

벡터의 덧셈(vector addition)이나 스칼라 곱(scalar multiplication)과 같은 기본적인 선형 연산(linear operations)은 그대로 유지된다.

이런 변환 과정에서 공간은 휘거나 비틀어지지 않고, 단지 회전, 늘어남, 축소와 같은 선형(linear) 변환만이 일어난다. 바로 이 "선형성"이 선형대수(linear algebra)라는 이름의 핵심이다.

Summary

Basis : 벡터 공간을 생성하는 선형 독립인 벡터들의 집합.

Linear independence : 어떤 벡터가 다른 벡터의 선형 결합으로 표현될 수 없다는 의미.

기저 벡터의 개수가 벡터 공간의 차원을 정의한다.

기저는 반드시 단위벡터나 직교 벡터일 필요는 없지만, 그렇게 하면 계산이 편리해진다.

좌표계를 변경하는 과정에서 선형성은 유지되며, 공간 자체가 변형되지는 않는다.

직교 기저를 선택하면 dot product을 통해 손쉽게 좌표 변환이 가능하며, 직교하지 않으면 matrix을 이용한 보다 일반적인 변환이 필요하다.

'학사 > 아주대 융시공' 카테고리의 다른 글

| [4학년][1학기][Coursera][Mathematics for ML][W8] (1) | 2025.04.28 |

|---|---|

| [4학년][1학기][Coursera][Introduction to HW and OS][W7] (0) | 2025.04.28 |

| [4학년][1학기][Coursera][Introduction to HW and OS][W6] (1) | 2025.04.28 |

| [4학년][1학기][Coursera][Introduction to HW and OS][W5] (0) | 2025.04.05 |

| [4학년][1학기][Coursera][Introduction to HW and OS][W4] (0) | 2025.03.30 |

[4학년][1학기][Coursera][Introduction to HW and OS][W7]

Introduction to Hardware and Operating System

Coursera - IBM

Link to Course

Module 5

Evaluating Computing Performance and Storage

Learning Objectives

- Identify the four key processor performance factors

- Evaluate RAM availability and usage

- Assess storage capacity and device types

- Understand network speed metrics and troubleshooting methods

Processor Performance Criteria

- Processor Speed (Clock Speed)

- Measured in GHz (Gigahertz)

- Higher speeds → faster task execution

- Number of Cores

- CPUs may have 2 to 64 cores

- More cores allow parallel task execution

- Related to Symmetric Multiprocessing (SMP)

- Bus Types and Speeds

- Address bus: sends memory addresses

- Data bus: carries data

- Control bus: sends control signals

- New standards: PCIe, HyperTransport, QPI

- Cache Memory

- Stores frequently used data for quick access

- Helps offset slower processing speeds

RAM (Random Access Memory)

- Temporary memory used to run apps, load websites, and edit files

- Measured in GB (Gigabytes)

- When RAM is full:

- Freezing, app crashes, blue screen, corrupted files

How to Check RAM in Windows:

- Open Task Manager → Performance → Memory

- Run Windows Memory Diagnostic for hardware issues

Storage Devices

| Type | Speed | Notes |

|---|---|---|

| SSD | Fastest | Flash-based, expensive but reliable |

| HDD | Moderate | Traditional spinning disks |

| Hybrid Drives | Balanced | SSD for cache + HDD for storage |

| Flash Memory | Varies | Portable (e.g., USB, SD cards) |

How to Check Disk Space:

- Open This PC from taskbar search → View under "Devices and Drives"

Network Speed & Connectivity

- Measured in Mbps or Gbps

- Use tools like speedtest.net to evaluate performance

How to Check Link Speed:

- Wi-Fi:

- Click Wi-Fi icon → Properties → Link Speed

- Ethernet:

- Search Ethernet Settings in Windows → View under Properties

Summary of Key Points

- Processor performance depends on speed, cores, bus type, and cache

- RAM availability impacts stability and multitasking

- SSD > Hybrid > HDD in terms of speed

- Check storage and RAM usage directly in Windows tools

- Use speed tests and network settings to assess connectivity issues

Workstation Evaluation and Setup

Learning Objectives

- Identify a user’s computing environment and requirements

- Evaluate computers based on hardware specifications

- Perform basic workstation setup tasks

Step 1: Understanding the User’s Needs

Location

- Office, home, mobile, or multi-site

Physical Conditions

- Desk, chair, lighting, outlets, security options, accessibility accommodations

Connectivity

- Wired for secure/confidential work

- Wi-Fi for general office/home use

- Cellular for mobile users

Data Storage Strategy

- Local, onsite network, or hybrid cloud

Step 2: Hardware & Peripheral Needs

| Component | Considerations |

|---|---|

| RAM | 8 GB (web-based users), 16 GB (standard), upgradeable (power users) |

| GPU | Required for graphics, big data tasks |

| Storage | Adequate for local files or cache use |

| Peripherals | Keyboard, mouse, monitor, speakers, scanner, etc. |

- Understand the connection type for each peripheral (USB, Bluetooth, etc.)

Step 3: Device Selection Considerations

- Desktops: Best performance, expandability

- Laptops/2-in-1s: Mobility, space-saving

- Evaluate:

- User needs

- Business requirements

- Available technology

- Budget constraints

Step 4: 6-Step Setup Process

- Reassess physical environment

- Unbox devices safely and read documentation

- Cable management

- Use short cables

- Bundle and label

- Electrical management

- Use labeled power cables

- Verify outlet amperage and accessibility

- Check ergonomics

- Monitor and chair height, arm and foot position, lighting

- Configure workstation

- OS settings: user login, keyboard, resolution

- Printer, audio, network, browser

- Remove bloatware

- Install productivity software

- Set up backup and security

Summary of Key Points

- A user’s job function, location, and accessibility guide the device decision

- The right hardware depends on task intensity (e.g., big data vs. email)

- A proper workstation setup involves:

- Environment check

- Unboxing and cable setup

- Ergonomic adjustments

- System configuration

Introduction to Troubleshooting

Learning Objectives

- Understand basic computer support concepts

- Apply troubleshooting procedures

- Use online and manufacturer support resources

- Summarize the CompTIA Troubleshooting Model

Basic Troubleshooting Concepts

- Determine the Problem

- Ask the user about recent changes

- Reproduce the issue

- Separate multiple problems

- Examine the Problem

- Check for simple causes (e.g., unplugged cable)

- Try multiple solutions

- If needed, escalate the issue

- Solve the Problem

- Create a plan, document steps

- Repair, replace, or combine both

- Confirm system functionality and finalize documentation

Common Computer Issues

- Loose cables, power issues

- BIOS or POST boot errors

- Blue/black screen

- OS problems or software crashes

- Monitor/display not working

Diagnostic Checklist

- Check for LEDs, power sounds

- Beep codes (use internet for decoding)

- Monitor connections

- Peripheral cables

Support Resources

- Search engines: Google, Bing, DuckDuckGo

- Online forums, community knowledge bases

- Manufacturer support pages and manuals

- Prepare:

- Device model, serial number

- Purchase date

- Issue description

CompTIA Troubleshooting Model

- Identify the Problem

- Gather info, duplicate, ask users, isolate issues

- Research

- Use knowledge bases or the internet

- Establish a Theory

- Question the obvious, divide & conquer

- Test the Theory

- Confirm or refine the theory

- Establish a Plan

- Consider all potential side effects

- Implement the Solution

- Escalate if necessary

- Verify Full System Functionality

- Apply preventive measures

- Document Everything

- Findings, steps, and outcomes

Summary of Key Points

- Troubleshooting is a step-by-step support method

- Start by identifying common, simple issues

- Use online and manufacturer resources for help

- Follow the CompTIA model for industry-standard troubleshooting

Advanced Microsoft Windows 10 Management and Utilities

Learning Objectives

- Perform advanced workstation management tasks

- Understand the role of drivers and how to update them

- Identify and use five essential Windows utilities

1. Policy Management

- Applies rules for:

- Passwords & retry limits

- Allowed programs

- User configurations

- Access via:

- Search “Group Policy” in Taskbar

- Edit group policy > User Configuration

2. Windows Task Manager

- Monitor apps and background processes

- Force quit with End Task

- Useful when software is frozen or unresponsive

3. Device Manager

- View and manage:

- Hardware components

- Interfaces (e.g., Intel ME Interface)

- Check status, update drivers, view resource use

- Useful for:

- Driver issues

- Firmware checks

4. Virtual Memory Management

- Use Task Manager to check RAM usage

- Open: Settings > Performance > Virtual Memory

- Adjust manually for high-memory apps

- Use Windows Memory Diagnostic for error checking

5. Service Management

- For advanced control of background services:

- Stop, restart, run, or ignore a service

- Optionally restart the system

- Helps resolve:

- Unresponsive software

- Resource bottlenecks

6. Drivers

- Enable communication between hardware and OS

- Symptoms of outdated drivers:

- Devices not working

- Use Device Manager > Right-click > Update Driver

7. Key Windows Utilities

| Utility | Function |

|---|---|

| Memory Diagnostics | Detect hardware memory errors |

| Performance Monitor | Monitor hardware and software performance |

| Event Viewer | Log system activity, errors, and install issues |

| Registry Editor | Modify program registration and disk location data |

| Task Manager | View and manage running tasks and processes |

Summary of Key Points

- Group Policy improves device and data security

- Task Manager and Device Manager are core tools for diagnosis

- Drivers must be current for proper hardware communication

- Windows provides built-in utilities for diagnostics and system management

Introduction to Business Continuity Principles

Learning Objectives

- Understand the importance of business continuity

- Evaluate a fault tolerance system

- Explain the importance of disaster recovery planning

What is Business Continuity?

- Business continuity: a plan to minimize disruption and maintain operations during difficult events

- Built upon fault tolerance, which enables systems to run even if some components fail

- Aims to prevent single points of failure

Redundancy: The Key to Continuity

Redundancy = Extra capacity or backup that protects against failure

Types of Redundancy:

- Data Redundancy

- Same data exists in multiple locations (e.g., backups)

- Risk: inconsistency

- Solution: real-time syncing

- RAID (Redundant Array of Independent Disks)

- RAID 0: Improved performance, no fault tolerance

- RAID 1: Mirroring data for fault tolerance

- RAID 5: Secure, requires minimum 3 HDDs

- Network Redundancy

- Multiple paths and adapters

- Load balancing across servers

- Site Redundancy

- Entire backup site in case of total loss (e.g., natural disaster)

- Uses replication to sync data across locations

- Power Redundancy

- Two independent power sources

- UPS (Uninterruptable Power Supply) as cost-effective fallback

Backup Strategies

Backup Methods:

- Full: All files

- Incremental: Files changed since last full/incremental

- Differential: Files changed since last full

- Daily: Only today's changes

Backup Devices:

- USB drives

- External HDDs

- LAN servers

- Tape storage

- Cloud-based storage

Key Considerations:

- Cost: Hardware, software, training

- Location: Cloud + additional physical site

- Storage/time balance for effective recovery

Disaster Recovery

- Plan to restore IT functionality after disruption

- Must include:

- Clear procedures

- Scenario-specific strategies

- Rapid execution and response

Summary of Key Points

- Business continuity requires planning, redundancy, and disaster recovery

- Fault tolerance systems avoid single-point failures

- Backup strategies should align with business needs and resources

- Disaster recovery plans restore IT operations after outages

'학사 > 아주대 융시공' 카테고리의 다른 글

| [4학년][1학기][Coursera][Mathematics for ML][W8] (1) | 2025.04.28 |

|---|---|

| [4학년][1학기][Coursera][Mathematics for ML][W5] (0) | 2025.04.28 |

| [4학년][1학기][Coursera][Introduction to HW and OS][W6] (1) | 2025.04.28 |

| [4학년][1학기][Coursera][Introduction to HW and OS][W5] (0) | 2025.04.05 |

| [4학년][1학기][Coursera][Introduction to HW and OS][W4] (0) | 2025.03.30 |

[4학년][1학기][Coursera][Introduction to HW and OS][W6]

Introduction to Hardware and Operating System

Coursera - IBM

Link to Course

Module 4

Internal Computer Components

Learning Objectives

- Recognize internal components of a computer

- Understand the role of the motherboard

- Evaluate how data flows among internal systems

Motherboard Overview

- The motherboard is the main printed circuit board (PCB)

- Hosts:

- CPU socket

- RAM slots

- Chipset (northbridge & southbridge)

- I/O and peripheral connectors

- Acts as the communication backbone of the computer

Chipset Architecture

| Component | Function |

|---|---|

| Northbridge | High-speed communication (CPU ↔ RAM, GPU); directly connected to CPU |

| Southbridge | Slower components (USB, audio, BIOS); not directly connected to CPU |

- Together, the chipset manages data flow between CPU, memory, and peripherals

Buses and Data Flow

- A bus is a high-speed pathway (printed circuitry) on the motherboard

- Transmits:

- Control signals

- Addresses

- Data

- Example: Front-Side Bus (FSB)

- Connects CPU ↔ Northbridge (memory controller)

CPU Socket Types

- Socket: Interface that connects CPU to motherboard

- Types of socket architecture:

- PGA (Pin Grid Array):

- Pins on CPU, holes on socket

- Align and insert carefully (no force)

- LGA (Land Grid Array):

- Pins on motherboard, flat contact pads on CPU

- Newer Intel CPUs typically use LGA

- PGA (Pin Grid Array):

Power Connectors

- Provide electrical current to motherboard and components

- ATX connector: A common large connector from power supply to motherboard

- Other connectors vary depending on form factor and power needs

Summary of Key Points

- Internal components are all elements attached to the motherboard

- The motherboard facilitates communication between CPU, memory, and peripherals

- Chipsets (northbridge and southbridge) manage data flow across key areas

- Buses are internal highways for data/control signals

- Sockets allow CPUs to connect to the motherboard and vary by CPU generation

- Power connectors supply electricity to the board and its components

Data Processing and Storage

Learning Objectives

- Recognize the role of memory in a computing system

- Distinguish between memory slots and expansion slots

- Understand the functions of the BIOS and CMOS

Central Processing Unit (CPU)

- CPU is a silicon chip with billions of transistors

- Executes calculations using data stored in memory

- 32-bit CPU: 2-lane data bus

- 64-bit CPU: 4-lane bus → double the data per clock cycle

- Found in laptops, desktops, and servers

RAM and Memory Slots

- RAM (Random Access Memory): Temporarily stores working data

- Volatile → data lost when power is off

- Installed in memory slots on the motherboard

- RAM is cold pluggable (must be powered off to install)

RAM Types:

| Type | Description |

|---|---|

| DRAM | Uses capacitors and transistors to store each bit |

| SDRAM | Synchronous DRAM; faster than standard DRAM |

| DDR / DDR3 / DDR4 | Double Data Rate; each generation is faster and more power-efficient |

| SO-DIMM | Compact RAM used in laptops; smaller but uses more power |

- RAM speed: Measured in MHz (e.g., 1333–2133 MHz)

Expansion Slots

- Memory slots: Only accept RAM

- Expansion slots (e.g., PCI / PCIe):

- Used for graphics cards, sound cards, network adapters

- Add features and capabilities to the system

- Number and type depend on motherboard model

Disk Controller

- Allows CPU to communicate with storage devices

- Example: IDE controller

- Chip-based circuit that manages hard drive read/write

- Often includes cache memory for performance boost

BIOS and CMOS

| Term | Function |

|---|---|

| BIOS | Firmware that handles input/output processes during startup |

| CMOS | Memory chip that stores BIOS configuration settings |

- BIOS is preprogrammed on the motherboard

- Can be updated ("flashed") with correct version (check with manufacturer)

- CMOS powered by coin-sized battery

- When CMOS battery dies:

- System clock resets

- Hardware settings are lost

Summary of Key Points

- Internal components like CPU, RAM, BIOS, expansion cards connect via the motherboard

- RAM is stored in memory slots and varies by type, size, and speed

- Expansion slots (PCI/PCIe) allow feature upgrades (e.g., graphics)

- BIOS controls startup and I/O functions; CMOS stores its settings

- CMOS battery must be replaced when expired to retain BIOS configuration

Internal Storage

Learning Objectives

- Describe hard drive architecture and data flow

- Compare characteristics of PATA, IDE, SATA, SCSI, SSD drives

- Understand optical drive technologies

- Identify the role of expansion slots in storage

Traditional Internal Hard Drives

- Introduced by IBM in 1956

- Provide non-volatile, long-term data storage

- Use spinning platters and actuator arms with read/write heads

- Key components:

- Power connector: Supplies power

- Data connector: Transfers data

- Jumpers: Configures specific drive settings

ATA, IDE, and PATA Drives

| Type | Description |

|---|---|

| IDE / ATA | Popular from 1980s–2003 |

| PATA | Parallel version of ATA |

| Speed | Ranged from 33 Mbps to 133 Mbps |

- Used ribbon cables for data connection

SATA Drives

- Introduced in 2003, using serial bus

- Much faster than ATA: up to 6 Gbps

- Common RPMs: 5400 / 7200

- Capacity: 250 GB to 30+ TB

- Standard for modern desktops and laptops

- Each SATA port supports one drive

SCSI Drives

- Known as "scuzzy"

- Introduced in 1986

- Fast (10,000–15,000 RPM)

- Discontinued around 1994

Solid-State Drives (SSD)

- Introduced in 1989

- Store data on non-volatile flash memory

- Faster than HDDs (up to 10–12 GB/s)

- Capacity: 120 GB to 2 TB (typically)

- More reliable but more expensive than SATA

- Also used in:

- External drives

- Hybrid drives (SSD as cache + SATA as storage)

Optical Drives

- Use CDs, DVDs, Blu-ray Discs

- Write/read via low-powered laser beam

- Store data in tiny pits on spiral tracks

Formats and Capacities

| Format | Storage | Notes |

|---|---|---|

| CD | Up to 750 MB | Single-sided |

| DVD | 4.7–17.1 GB | Single or dual-sided |

| Blu-ray | 25–128 GB (per layer) | High-res video/audio, DRM by region |

- BD-XL drives needed for triple/quad-layer Blu-rays

Expansion Slots

- On the motherboard, used for:

- Adding storage controllers

- Supporting additional drives

Summary of Key Points

- Internal hard drives offer fast access and long-term, non-volatile storage

- SATA drives are standard today due to cost-efficiency and capacity

- SSDs are faster and more reliable but costlier

- Optical drives offer portable storage and are still used for media

- Blu-ray Discs support high-resolution content and regional protection

- Expansion slots allow extending storage capabilities via add-on cards

Display Cards and Sound Cards

Learning Objectives

- Define the function of a video card (GPU)

- Understand how sound cards handle audio signals

- Evaluate the role of MIDI controllers in audio production

Video Cards (Graphics Cards)

- Also called:

- Display adapter, Graphics card, Video adapter, GPU

- May be:

- Integrated (on the motherboard)

- Dedicated (plugged into an expansion slot)

Functions:

- Sends graphical data to:

- Monitors, TVs, Projectors

- Uses a Graphics Processing Unit (GPU) to:

- Accelerate graphics rendering

- Perform parallel processing for:

- Gaming

- Video editing

- Machine learning

Sound Cards (Audio Cards)

- Generate and process audio signals

- Functions:

- Analog-to-digital conversion (ADC):

- E.g., Microphone → Digital file

- Digital-to-analog conversion (DAC):

- E.g., MP3 → Speaker output

- Analog-to-digital conversion (ADC):

- Can be:

- Integrated on the motherboard (common in most PCs)

- Dedicated expansion cards (for higher quality sound)

MIDI Controllers

- MIDI (Musical Instrument Digital Interface): Standard for digital musical instruments

- MIDI Controller:

- Sends digital signals to PC or synthesizer

- Allows sequencing, recording, and virtual instrument control

- Commonly used by musicians for composing and producing music

Summary of Key Points

- Video cards (GPUs) process and send image data to displays

- Sound cards convert audio signals between analog and digital

- Integrated audio is usually sufficient for general users

- Dedicated sound cards are preferred for audio production

- MIDI controllers are essential tools for digital musicians, sending control signals to PCs and sound modules

Cooling and Fans

Learning Objectives

- Define system cooling

- Compare air cooling, passive cooling, and liquid cooling

- Evaluate the efficiency and trade-offs of liquid cooling

What Is System Cooling?

- Computers generate heat during operation

- System cooling prevents overheating of internal components

- Without proper cooling, parts like the CPU can be damaged

Cooling Methods

1. Passive Cooling

- Slows down the component's operating speed to reduce heat

- No moving parts (e.g., simple heatsinks without fans)

2. Active Cooling (Air Cooling)

- Uses powered fans to move air through the case

- Cool air drawn in from front vents, hot air expelled out the back

- Forced convection with heatsink + fan setup:

- Thermal paste fills microscopic gaps for better heat transfer

- Fan blows air over heatsink fins to dissipate heat

3. Liquid Cooling

- Similar to radiator systems in cars

- Circulates liquid through water blocks placed on hot chips (e.g., CPU, GPU)

- Heated liquid → radiator → cooled via fans → recirculates

- Quieter and more efficient, especially for:

- High-performance PCs

- Hot environments

Advantages and Disadvantages of Liquid Cooling

| Advantage | Disadvantage |

|---|---|

| Quiet operation | Higher cost |

| Efficient heat transfer | Risk of leakage inside system |

| Effective in high-heat setups | Requires more maintenance |

Summary of Key Points

- System cooling is essential to protect components from heat damage

- Air cooling uses heatsinks, thermal paste, and fans

- Passive cooling slows down performance to reduce heat

- Liquid cooling is quieter and more effective, but costly and riskier

- Best choice depends on system use, heat level, and budget

'학사 > 아주대 융시공' 카테고리의 다른 글

| [4학년][1학기][Coursera][Mathematics for ML][W5] (0) | 2025.04.28 |

|---|---|

| [4학년][1학기][Coursera][Introduction to HW and OS][W7] (0) | 2025.04.28 |

| [4학년][1학기][Coursera][Introduction to HW and OS][W5] (0) | 2025.04.05 |

| [4학년][1학기][Coursera][Introduction to HW and OS][W4] (0) | 2025.03.30 |

| [4학년][1학기][Coursera][Introduction to HW and OS][W3] (0) | 2025.03.30 |

[4학년][1학기][Coursera][Introduction to HW and OS][W5]

Introduction to Hardware and Operating System

Coursera - IBM

Link to Course

Module 3

Identifying Ports and Connectors

Learning Objectives

- Define what a port and connector are

- Differentiate between a port and an interface

- Identify common ports and connectors used in computing

Definitions

- Port: A hole or slot on a computer that receives a connector to establish a physical link

- Connector: The plug at the end of a cable or card that fits into a port

- Interface: A point of communication between two entities, can be hardware or software

Common Interfaces and Ports

USB (Universal Serial Bus)

- Designed to standardize and simplify device connections

- Major versions:

- USB 1.0 (1996): 1.5–12 Mbps

- USB 2.0 (2001): 480 Mbps

- USB 3.0/3.1/3.2 (2008–2017): Up to 20 Gbps

- USB4 (2019): Up to 40 Gbps using Type-C

- Connector types:

- Type A: Rectangular (keyboards, mice)

- Type B: Square with beveled corners (printers, scanners)

- Mini USB: Small, 9-pin (older mobile devices)

- Micro USB: Smaller, 5-pin (newer small devices)

- Type-C: Reversible 24-pin, supports high-speed data and power

Thunderbolt

- Developed by Intel and Apple

- Versions 1 & 2 use Mini DisplayPort (MDP) connector

- Versions 3 & 4 use USB-C connector

- Combines data, display, and power in one cable

- Supports daisy chaining up to 6 devices

- Thunderbolt 4 supports:

- USB4 protocol

- Dual 4K displays

- Alternate hubs (not just daisy chaining)

FireWire (IEEE 1394)

- Legacy interface used on Macintosh computers

- Versions:

- FireWire 400: Slim with one rounded edge

- FireWire 800: Looks similar to USB but thicker

- Replaced by USB and Thunderbolt, but still in use in legacy/industrial systems

PS/2 Ports

- Introduced by IBM for connecting keyboards and mice

- Round with 6 pins

- Color-coded and not interchangeable

- Still used in some industrial and gaming systems

eSATA / eSATAp

- Used for connecting external storage devices

- Supports hot swapping

- eSATAp supports USB and eSATA in one port

- Three generations, each doubling in data speed

Summary of Key Points

- Port = physical slot for device connection

- Connector = plug inserted into the port

- Interface = communication link (hardware or software)

- Key interfaces: USB, Thunderbolt, FireWire, PS/2, eSATA

- Type-C and Thunderbolt are replacing older standards due to higher speed and flexibility

Identifying Graphic Devices

Learning Objectives

- Understand how graphic devices (GPUs) operate on a computer

- Recognize key characteristics of the display system

- Identify different types of display connectors and their uses

Graphics Devices and GPUs

- Graphics Processing Unit (GPU) handles display communication

- Integrated GPUs: built into the motherboard, suitable for everyday tasks

- Dedicated GPUs: needed for 3D gaming, multimedia editing

- Popular chipsets: AMD Radeon, NVIDIA GeForce/nForce, Intel, SiS, VIA

Display Quality Factors

| Factor | Description |

|---|---|

| Resolution | Number of horizontal × vertical pixels (e.g., 1920×1080) |

| Refresh Rate | How fast screen updates (e.g., 60Hz, 120Hz) |

| Bit/Color Depth | Number of colors supported (e.g., 16-bit, 32-bit) |

- Higher values = sharper images, smoother video, more realistic colors

- More processing power is required for higher display quality

Display Types and Standards

CRT (Cathode Ray Tube):

- 4:3 aspect ratio

- VGA (640×480), SVGA (800×600), XGA (1024×768)

Modern LED displays:

- 16:9 widescreen

- Resolutions:

- HD: 1280×720

- Full HD: 1920×1080

- 4K UHD: 3840×2160

- 8K: 7680×4320

Display Connectors

HDMI (High Definition Multimedia Interface)

- Most widely used for audio/video

- Supports CEC, HDCP

- 19-pin connector:

- HDMI (standard)

- HDMI Mini

- HDMI Micro

- HDMI 2.1 supports up to 8K resolution

DisplayPort (by VESA)

- Royalty-free alternative to HDMI

- Uses packetized data for efficient transmission

- 20-pin connector; supports 7 transmission modes

- Common in high-end monitors and graphics cards

Thunderbolt (Intel + Apple)

- Combines display, data, and power in one cable

- Thunderbolt 1 & 2: Mini DisplayPort

- Thunderbolt 3 & 4: USB-C

- Thunderbolt cables are not interchangeable with regular USB-C

DVI (Digital Visual Interface)

- Uncompressed digital video; supports analog + digital

- Types:

- DVI-I: integrated

- DVI-A: analog only

- DVI-D: digital only

- Single-link and dual-link formats (for higher resolutions)

VGA (Video Graphics Array)

- Legacy analog interface with 15-pin connector

- Still supported on some devices, but outdated

Other Connectors

- Mini DisplayPort: used by Apple, supports up to 4K

- USB: Some monitors/cameras use USB Type A or C

- S-Video: Used by old TVs and VCRs (analog)

- Component RGB: Splits analog video into 3 color signals, plus audio

Summary of Key Points

- Computers need GPUs to render visuals on a display

- Display quality depends on resolution, refresh rate, and bit depth

- CRTs used 4:3 aspect ratio; modern displays use 16:9 LED screens

- Connectors like HDMI, DisplayPort, Thunderbolt, DVI, VGA each offer unique advantages

Identifying Audio Connectors

Learning Objectives

- Understand how audio devices connect to a computer

- List different types of audio connectors

- Identify connectors by type: TRS, Bluetooth, USB, etc.

Audio Devices and Sound Cards

- Computers use internal expansion cards (a.k.a. sound cards) to process audio

- Digital-to-Analog Converters (DACs) allow analog devices to connect to computers

- Use cases:

- Listening to music

- Recording/editing audio/video

- Gaming

- Presentations

- Teleconferencing

Common Audio Connection Types

| Connector Type | Description |

|---|---|

| Sound card ports | 3.5mm or 6.35mm TRS jacks |

| Bluetooth | Wireless audio interface |

| Game port (legacy) | 15-pin MIDI/audio port, now obsolete |

| USB | For headsets, microphones, interfaces |

| External audio interface | High-quality, multi-device professional use |

Sound Card Ports

- Common labels and color codes:

- Light blue: Line-in

- Pink: Microphone-in

- Lime green: Line-out (speakers/headphones)

- Black: Rear speakers (surround)

- Orange: Mid-surround (center/subwoofer)

- Accept:

- 6.35mm TRS jack (professional equipment)

- 3.5mm TRS mini-jack (consumer use)

Bluetooth Connections

- Built-in on most modern laptops/desktops

- Can connect:

- Wireless headsets

- Bluetooth speakers

- USB Bluetooth dongles available for older systems

Game Ports (Legacy)

- MIDI interface with 15-pin connector

- Used for older gaming controllers and audio

- Now replaced by USB-based controllers

External Audio Interfaces

- Connect multiple devices (mics, amps, speakers)

- Used in professional/studio settings

- Connect via:

- USB

- FireWire

- Thunderbolt

- Require specific drivers for operation

Summary of Key Points

- Sound cards process audio in/out with analog and digital signals

- Audio devices connect via:

- TRS jacks

- Bluetooth

- USB

- External interfaces

- Older game ports are now obsolete

- External interfaces offer high-quality multi-channel audio for professionals

스크립트 한국어 번역

Identifying Audio Connectors 강의에 오신 것을 환영합니다.

이 영상을 시청한 후, 여러분은 오디오 장치가 컴퓨터에 어떻게 연결되는지 설명하고,

다양한 오디오 커넥터의 유형을 나열하며,

연결 방식에 따른 오디오 커넥터를 식별할 수 있게 됩니다.

Wired and Wireless Connections

Learning Objectives

- Understand how devices communicate through networks

- Identify wired vs. wireless connections

- Recognize key connectors and technologies (RJ-11, RJ-45, Wi-Fi, Bluetooth, RFID, NFC)

Overview of Network Connections

- Devices communicate via data packets, similar to labeled envelopes

- Networks can be:

- Closed (limited devices) or

- Open (e.g., the Internet)

- Connections are either:

- Wired (Ethernet)

- Wireless (Bluetooth, Wi-Fi, NFC, RFID)

Wired Connections

RJ Connectors

| Type | Use Case |

|---|---|

| RJ-11 | Telephones, handsets |

| RJ-45 | Computers, modems, routers, POS terminals, gaming consoles |

- RJ connectors include a plastic locking tab

- RJ-45 supports Ethernet LANs

Advantages of Wired Connections

- Faster: Up to 5 Gbps

- Stable & secure: not affected by weather, no signal drop

- Less interference → fewer retransmissions

- More difficult to hack

Wireless Connections

Wi-Fi

- Connects phones, computers, TVs to Internet

- Uses wireless router connected to modem

- Routers often built-in to modems now

Bluetooth

- Since 1998

- Short-range (e.g., ~10m), uses UHF radio

- Devices connect via pairing with passkeys

RFID (Radio Frequency Identification)

- Uses tags and readers

- Range: several hundred meters

- Common uses:

- Toll booths

- Pet/livestock ID

- Retail checkout

- Pharma tracking

NFC (Near Field Communication)

- Evolution of RFID

- Extremely short range (a few cm)

- Requires both devices to have NFC chips

- More secure and power-efficient

- Use cases:

- Hotel keycards, mobile payments, office access

Wireless vs. Wired Networks

| Category | Wired | Wireless |

|---|---|---|

| Speed | Faster | Slower, but improving |

| Setup | Complex (cabling required) | Easy and quick |

| Mobility | Limited | High mobility |

| Scalability | Costly, limited by wiring | Easy to expand |

| Cost | Higher | More economical |

Summary of Key Points

- Devices connect via wired (RJ-11, RJ-45) or wireless (Wi-Fi, Bluetooth, RFID, NFC) technologies

- Wired connections are faster and more secure, but less flexible

- Wireless connections offer mobility, easy setup, and scalability

- NFC is a secure, short-range evolution of RFID, used in tap-to-pay, access cards, etc.

Peripheral and Printer Connections

Learning Objectives

- List common connection methods for printers and peripherals

- Understand how to connect via serial, parallel, USB, and network ports

- Use Windows Settings to install and configure printers

Recognizing Peripheral Devices

- Computers use Plug and Play (PnP) software to auto-detect peripherals

- If PnP fails:

- Visit manufacturer’s website to download drivers

- Generic drivers may offer basic functionality

- For advanced features (e.g., scan, fax), install manufacturer-specific application software

Connection Methods

| Type | Description |

|---|---|

| USB | Most common wired connection (fast, simple) |

| Wi-Fi / Bluetooth / NFC | Common wireless methods for peripherals |

| Serial Port (RS232) | Slow, older connection using 9-pin cable; long distance, noise-resistant |

| Parallel Port | Faster than serial; 25-pin cable; supports multiple bits simultaneously |

| Network | Wired (Ethernet) or wireless (Wi-Fi); allows multi-device access |

Serial & Parallel Ports

Serial Port (RS232):

- 9-pin connector

- Slower but long-distance capable

- Screws used to secure connection

Parallel Port:

- 25-pin connector

- Sends multiple bits at once

- Also secured with side screws

Network Printer Installation (Windows)

- Verify network connection

- Go to:

Settings > Devices > Printers & scanners - Click:

+ Add a printer or scanner - Let Windows detect or click:

"The printer that I want isn't listed"for manual setup

- Select options for:

- Older printers

- Bluetooth printers

- Network printers

Summary of Key Points

- Drivers enable printer/computer communication

- Basic features may work with generic drivers, but full features need manufacturer software

- Serial (9-pin) and parallel (25-pin) connections are older but still in use

- Use Windows Settings to detect or manually install printers

- Network printers require active network connectivity and can be installed wirelessly or via Ethernet

Installation Types

Learning Objectives

- Define hardware and software installation

- Compare Plug and Play (PnP) vs. manual driver installation

- Understand IP-based and web-based configuration

What Is Installation?

- Installation: Preparing hardware/software for use

- Can vary by complexity:

- Simple: Performed by general users

- Complex: May require technical expertise

Plug and Play (PnP)

- PnP: Automatically recognized and installed by OS

- No need for user to manually install drivers

- Common PnP devices: Mouse, Keyboard, USB drives

- If not working:

- Check Device Manager for issues (yellow warning icons)

- Update the driver if outdated or malfunctioning

Steps to Update a Driver (Windows 10):

- Search and open Device Manager

- Expand device category

- Right-click device → Select Update driver

Manual Driver Installation

- Necessary when:

- Device is not supported by default drivers

- PnP fails

- Requires downloading driver from manufacturer website

- Sometimes needed to access advanced features

IP-Based Peripherals

- Hardware that connects over TCP/IP network

- Examples:

- Wireless access points

- IP security cameras

- Network printers or print servers

- Must be connected to LAN or Internet to operate

Web-Based Configuration

- Common for networking devices (e.g., routers)

- Setup is done via a web interface (e.g., http://192.168.0.1)

- Configuration options include:

- Network name (SSID)

- Passwords

- IP settings

Summary of Key Points

- Installation is required before use; configuration customizes settings

- PnP offers faster setup than manual driver installs

- Driver installation is sometimes needed for full device functionality

- IP-based and web-based setups require network/internet access

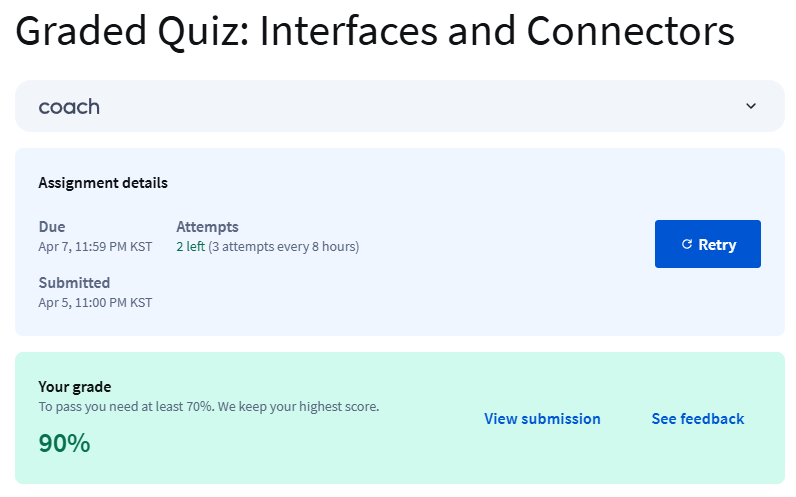

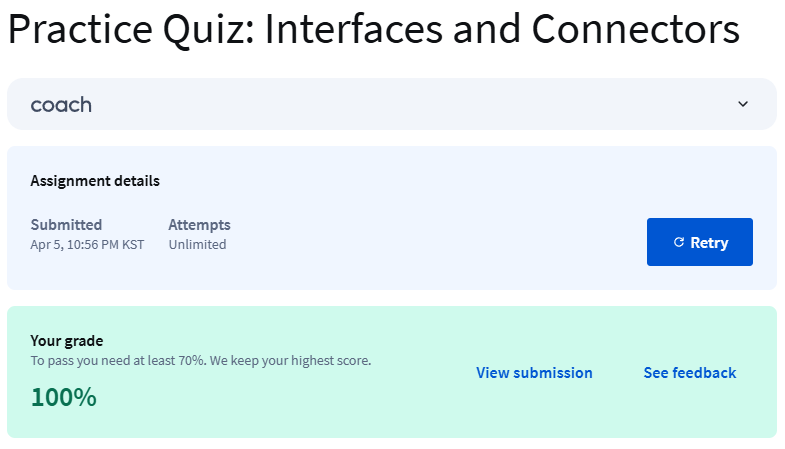

Practice Assigment & Graded Assignment

- 100점, 90점으로 pass

'학사 > 아주대 융시공' 카테고리의 다른 글

| [4학년][1학기][Coursera][Introduction to HW and OS][W7] (0) | 2025.04.28 |

|---|---|

| [4학년][1학기][Coursera][Introduction to HW and OS][W6] (1) | 2025.04.28 |

| [4학년][1학기][Coursera][Introduction to HW and OS][W4] (0) | 2025.03.30 |

| [4학년][1학기][Coursera][Introduction to HW and OS][W3] (0) | 2025.03.30 |

| [4학년][1학기][Coursera][Introduction to HW and OS][W1] (0) | 2025.03.23 |

[4학년][1학기][Coursera][Introduction to HW and OS][W4]

Introduction to Hardware and Operating System

Coursera - IBM

Link to Course

Module 2

Identifying Hardware Components and Peripherals

Learning Objectives

- Explain the difference between internal and external components

- Describe what a peripheral device is and what it does

- Understand and contrast the concepts of interface, port, and connector

What is a Computer Component?

- A component is a physical part of the computer, also known as hardware

- Each component performs a specific function

- Components are classified as either:

- Internal (inside the computer)

- External (connected via ports)

Examples of Internal Components

- RAM (Random Access Memory):

- Temporary memory, used while power is on

- Data is lost when power is shut off

- Hard Drive:

- Permanent storage for files

- Data is retained even when power is off

- CPU (Central Processing Unit):

- Performs mathematical calculations

- Known as the "brain" of the computer

- Faster CPU = more operations handled simultaneously

What is a Peripheral?

- A peripheral is a device that connects to a computer to extend functionality

- Used for data input, output, or storage

- Can be easily connected and disconnected

- Connected through a connector

Types of Peripherals

- Input Devices: send data to the computer

- e.g., Mouse, Keyboard

- Output Devices: receive data from the computer

- e.g., Monitor, Printer

- Storage Devices: store data permanently

- e.g., External Hard Drive, USB Flash Drive

Connector vs. Port

- Connector: the end of a plug, jack, or card that connects into a port

- Internal Example: Expansion card’s edge connecting to motherboard slot

- External Example: USB plug at the end of a cable

- Port: the physical opening (jack/receptacle) on a computer where a connector is inserted

- Ports are standardized

- Common types include:

- USB (Universal Serial Bus)

- HDMI (High-Definition Multimedia Interface)

Summary of Key Points

- A component is any physical hardware part necessary for computer operation

- Internal components include RAM, CPU, and hard drive

- External components include ports and connectors

- A connector fits into a port, and both enable communication between the computer and peripherals

- A peripheral device can connect either externally (e.g., USB printer) or internally (e.g., expansion card)

Input and Pointing Devices

Learning Objectives

- Compare various input devices

- Identify which devices use a touchpad

- Define a pointing device

What is a Pointing Device?

- A pointing device is used to move the cursor and interact with objects on the screen

- All pointing devices send commands (as data) to the computer

Examples of Pointing Devices:

- Mouse

- Keyboard

- Joystick

- Touchpad

- Trackball

- Stylus / Pointing Stick

Input Devices Overview

Keyboard

- Primarily used for typing and data input

- Connects via USB or older PS/2 port

- To add a new keyboard layout in Windows 10:

- Open Settings

- Go to Time & Language → Language

- Choose your preferred language → Options

- Under "Keyboards", click Add a keyboard

Mouse

- Most common pointing device

- Connects via USB or Bluetooth

- Cursor and sensitivity settings adjustable in Windows Settings

Touchpad

- Built-in pointing device on most laptops

- Can also be used externally via USB or Wi-Fi

Camera

- Captures digital images (also considered an input device)

- Usually built-in on laptops

- External cameras connect via USB or Bluetooth

Joystick

- Used for gaming, moves cursor and sends commands

- Connects via USB or Bluetooth

Trackball

- Stationary input device (alternative to mouse)

- Suitable for users with mobility limitations

Stylus / Pointing Stick

- Often used on tablets for navigation

- Works using capacitive sensing (detects heat and pressure)

Summary of Key Points

- Input devices send data to the computer and move the cursor

- Common input devices: keyboard, mouse, touchpad, joystick, trackball

- Touchpad functions like a mouse and is typically built into laptops

- Pointing devices include any tool (mouse, stylus, etc.) that allows user interaction through cursor movement and command input

Hard Drives

Learning Objectives

- Identify an internal storage device

- Describe the characteristics of a hard drive

- Apply performance knowledge to choose the best hard drive

What is a Storage Device?

- Storage devices store digital data (images, videos, audio, text)

- Two types of internal storage:

- ROM (Read-Only Memory):

- Non-volatile (retains data without power)

- Used for booting the computer and storing permanent data

- RAM (Random Access Memory):

- Volatile (temporary memory)

- Data is lost when power is off

- ROM (Read-Only Memory):

Hard Drive Overview

- Hard drive = HDD (Hard Disk Drive): terms used interchangeably

- Stores data on magnetic platters using a drive head

- Form factors:

- 2.5”: Used in laptops and mobile devices

- 3.5”: Used in desktop computers (higher capacity)

- Common storage sizes:

- From 500GB to several TB (terabytes)

Types of Hard Drives

- SATA (Serial ATA): Most common interface, faster

- PATA (Parallel ATA): Older, slower interface

Performance Characteristics

| Metric | Description |

|---|---|

| Spin speed | Measured in RPM, common values: 5400 / 7200 |

| Access time | Time to locate data (typically 5–10 ms) |

| Transfer rate | Speed of data transfer (in MBps) |

How to Check Disk Space (Windows 10)

- Type This PC in the taskbar → Press Enter

- Click Open

- Under Devices and drives, view disk space availability

How to Install an Internal Hard Drive

- Backup data before installation

- Transfer or remove drive enclosure if needed

- Insert new HDD into the slot, secure with screws (2 per side recommended)

- Connect HDD to motherboard via SATA or PATA cables

- Connect power supply to the hard drive

How to Configure Hard Drives (Windows)

- Log in as Administrator

- Right-click My Computer → Select Manage

- Go to Disk Management in the console tree

- Use View menu to customize layout (Top or Bottom panes)

Summary of Key Points

- Hard drives store all types of digital media

- HDDs are considered ROM (non-volatile, permanent storage)

- Performance is determined by RPM, access time, transfer rate

- Choose your HDD based on required capacity and speed

- Follow correct installation steps and back up your data

- Configure HDD settings via Disk Management in Windows

Optical Drives and External Storage

Learning Objectives

- Understand how an optical drive records data

- Describe an external storage device

- Apply knowledge of expansion devices to choose the right option for your needs

Optical Drives

- Use a laser to “burn” or press data onto a reflective disc surface

- Create pits (recessed areas) and lands (raised areas)

- Single-sided discs: one data layer

- DVD: ~4.7 GB

- CD: ~700 MB

- Double-sided discs: two data layers → twice the capacity

- Types of Optical Drives:

- CD-ROM, CD-RW

- DVD-ROM, DVD-RW

- Blu-ray: up to 50 GB

- Writers (CD-R/DVD-R) use lasers for reading/writing

Solid-State Drive (SSD)

- Uses flash memory, with no moving parts

- Faster and more durable than HDDs

- Serves as permanent secondary storage

External Hard Drives

- Ideal for backups and file transfers

- Store documents, music, videos, presentations, etc.

- Connect via USB or eSATA

- eSATA: signal only (requires external power supply)

- Plug-and-play with Windows

- File Explorer usually opens automatically

Expansion Drives

- Provide extra storage

- Connect via USB

- Automatically recognized by Windows OS

- Examples:

- USB flash drives:

- Flash memory with USB interface

- Removable, rewritable

- Storage up to 2 TB

- Memory cards:

- Common formats: SD, MicroSD

- Capacities: 32 GB, 64 GB, 128 GB, up to 512 GB

- USB flash drives:

Mobile Storage Devices

- Portable media players and smartphones handle digital media

- File types: music, audiobooks, videos

- Internal memory:

- Fixed storage (e.g., 16GB, 32GB, 64GB)

- OS and pre-installed apps consume part of it

- Expandable memory:

- Via microSD cards (if supported)

- Important for users who store lots of files

Summary of Key Points

- Optical drives use a laser to write data to discs

- External hard drives and USB drives are solid-state (no moving parts)

- SSDs are faster but more expensive than HDDs

- Expansion storage increases overall capacity via USB or memory cards

- Consider your storage needs and budget when selecting a device

- Mobile devices also serve as portable media storage solutions

Display Devices

Learning Objectives

- Define what a display device is

- Identify different types of display devices (e.g., CRT, LCD, touchscreen, projector)

- Adjust screen resolution and manage devices in Windows Device Manager

What is a Display Device?

- A hardware component for the visual output of information

- Used in computers, televisions, mobile devices

- Tactile monitors are available for visually impaired users (fingertip-readable output)

Types of Display Devices

CRT (Cathode Ray Tube)

- Analog display using electron beams to light up phosphor dots

- Common in older TVs and computer monitors (mid–late 1900s)

- Resolution: up to 800×600 or 1024×768

LCD / TFT (Flat Screens)

- Digital displays, replacing CRT

- Use pixels controlled by electrical signals

- Lighter, thinner, sharper than CRT

Touchscreen

- Input + Output device

- Detects heat and pressure (capacitive technology)

- Used in smartphones, tablets, laptops

Projector

- Projects still or moving images from a computer onto a surface (e.g., wall, whiteboard)

Resolution and Display Settings

- Resolution = clarity/sharpness of text and images

- Higher resolution (e.g., 1600×1200) = sharper display

- Change in Windows 10:

- Settings → System → Display → Adjust Resolution

Device Installation and Management

- Windows supports Plug-and-Play

- No restart needed for hot-swappable devices (e.g., monitors)

- Windows auto-installs drivers when a display device is connected

- To manually install drivers:

- Download from vendor website → Run setup program

- To uninstall a display device:

- Open Device Manager

- View → Show Hidden Devices

- Find device type → Right-click → Uninstall

- Optionally: Delete the driver software

- Click OK to complete

Multiple Monitors (Windows 10)

- Connect monitors → Press Windows + P

- Choose:

- Duplicate: same screen on both

- Extend: extend display across monitors

Summary of Key Points

- Display devices include CRT, LCD/TFT, touchscreens, and projectors

- CRTs are analog; LCDs and touchscreens are digital

- Screen resolution can be adjusted in Display Settings

- Plug-and-play makes device connection easy

- Use Device Manager to uninstall or manage display hardware

Printers and Scanners

Learning Objectives

- Describe the function of an output device

- Learn how to install a printer in Windows

- Identify different types of printers

- Understand what a scanner and multifunction device (MFD) do

What is an Output Device?

- Hardware that converts processed data into human-readable form

- Output can be:

- Text

- Graphics

- Tactile (e.g., braille)

- Audio

- Video

Examples of Output Devices:

- Monitors, Printers, Speakers, Headphones, Projectors

- Others: GPS devices, sound/video cards, optical mark readers, braille readers

- Speech synthesizers: produce verbal output (e.g., text-to-speech)

A computer can run without an output device, but you won’t be able to see or hear what it’s doing.

Printer Types

| Printer Type | Description |

|---|---|

| Laser | Uses heated unit to fuse toner on paper |

| LED | Similar to laser; uses a photoreceptive drum |

| Inkjet | Sprays microscopic ink droplets using thousands of tiny nozzles |

| Thermal | Heats special coated paper to create black text/images (used in POS, fax machines) |

Printer Connection Types

- Local printer: directly cabled to the device

- Network printer: accessed via Wi-Fi or Ethernet

- IP-based printer: used in networks (e.g., UNIX)

- Web-based printer: receives print jobs via Internet

How to Install a Printer in Windows 10